No Amazon S3 (Simple Storage Service), objetos duplicados se referem a arquivos ou objetos dentro de um ou vários buckets com conteúdo idêntico. Essas duplicatas podem ocorrer por vários motivos, como uploads acidentais, vários uploads do mesmo arquivo ou processos de sincronização.

É importante observar que objetos duplicados podem aumentar custos de armazenamento já que cada objeto é cobrado separadamente com base no tamanho e na duração do armazenamento. Portanto, é geralmente recomendado que objetos duplicados sejam gerenciados de forma eficiente, evitando-os por meio de convenções de nomenclatura adequadas ou usando versionamento quando necessário.

Objetos duplicados no AWS S3 podem apresentar vários desafios e problemas potenciais. Objetos duplicados consomem espaço de armazenamento adicional, levando a custos de armazenamento mais altos. Manter o controle de várias cópias dos mesmos dados pode se tornar desafiador, especialmente em ambientes com uploads e atualizações de dados frequentes. Muitos objetos duplicados em um bucket do S3 podem afetar o desempenho, especialmente ao listar, acessar ou gerenciar objetos. Isso pode resultar em tempos de resposta mais lentos e maior latência para operações de bucket. Objetos duplicados podem levantar preocupações de conformidade e governança, especialmente em setores regulamentados onde a duplicação de dados pode levar a problemas com políticas de retenção de dados, regulamentações de privacidade de dados e requisitos de auditoria.

O OptScale pode ajudar a mitigar esses problemas. É essencial auditar os buckets do S3 para objetos duplicados regularmente. Além disso, a ferramenta pode ajudar a identificar e lidar com objetos duplicados proativamente.

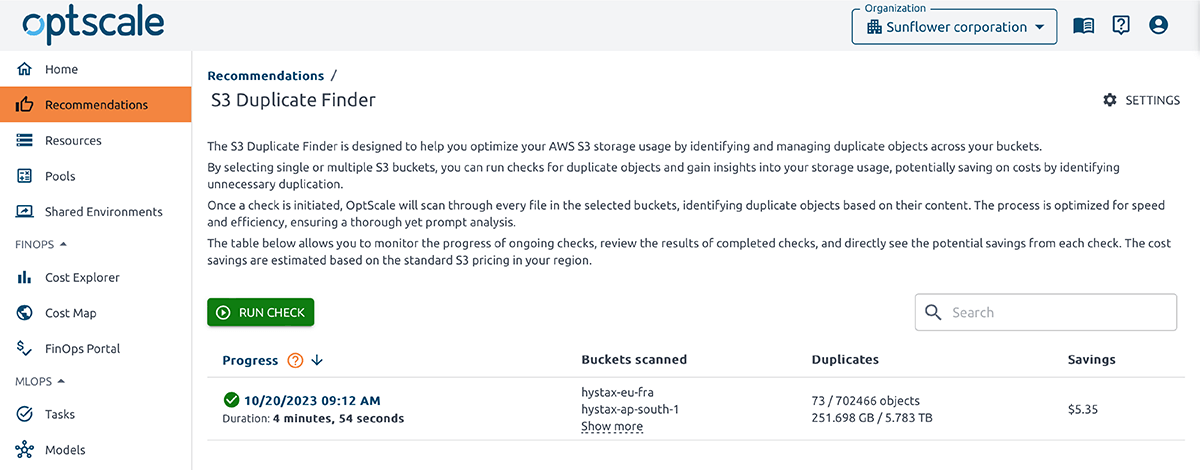

O OptScale permite encontrar objetos duplicados no AWS S3. O S3 Duplicate Finder (como é chamado no produto) foi projetado para ajudar você a otimizar seu uso de armazenamento no AWS S3 identificando e gerenciando objetos duplicados em seus buckets.

Selecionar um ou vários buckets S3 permite que você execute verificações de objetos duplicados e obtenha insights sobre seu uso de armazenamento. Ao identificar duplicações desnecessárias, você pode economizar em custos.

Uma vez que uma verificação é iniciada, o OptScale escaneará todos os arquivos nos buckets selecionados, identificando objetos duplicados com base em seu conteúdo. O processo é otimizado para velocidade e eficiência, garantindo uma análise completa, mas rápida.

Como executar uma verificação de objetos duplicados no OptScale?

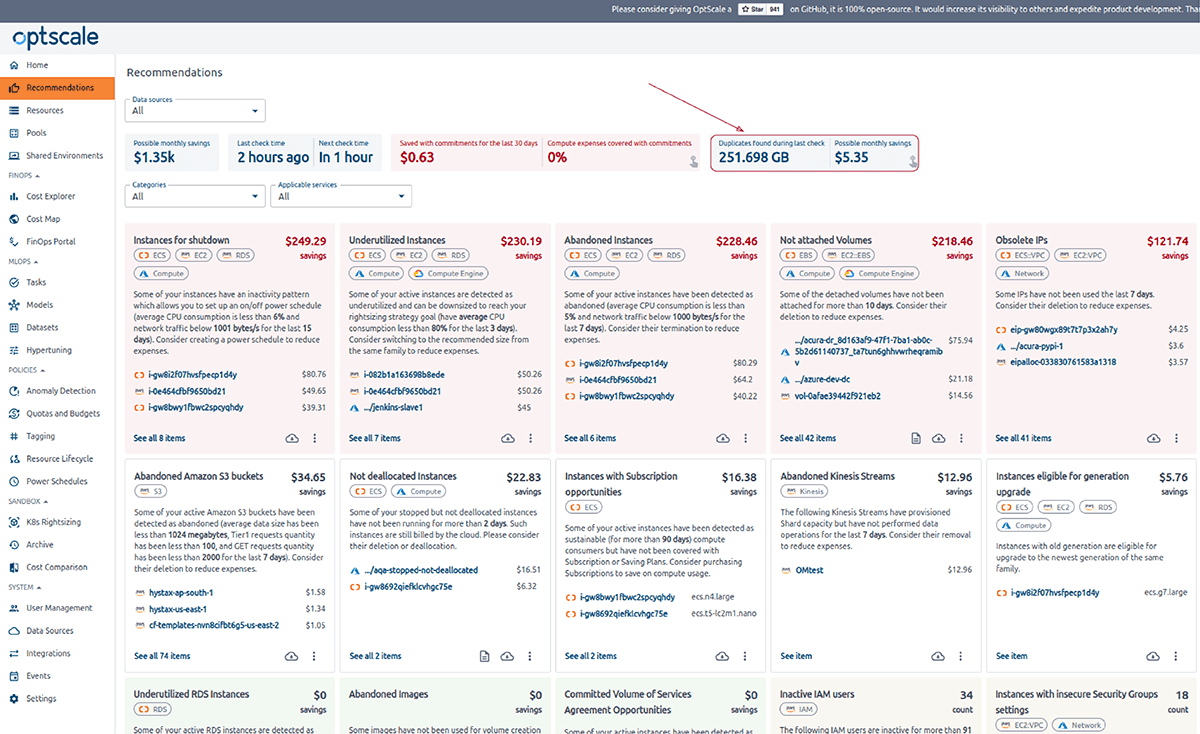

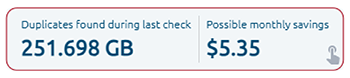

O ponto de entrada para a página do localizador de duplicatas do AWS S3 é um cartão "Ir para o localizador de duplicatas do S3" na página "Recomendações".

Ele mostra duplicatas encontradas durante a última verificação e possíveis economias mensais.

O cartão pode estar em diferentes estados, dependendo das condições.

Nenhuma verificação foi concluída com sucesso ou nenhuma verificação foi iniciada

Última informação de verificação bem-sucedida

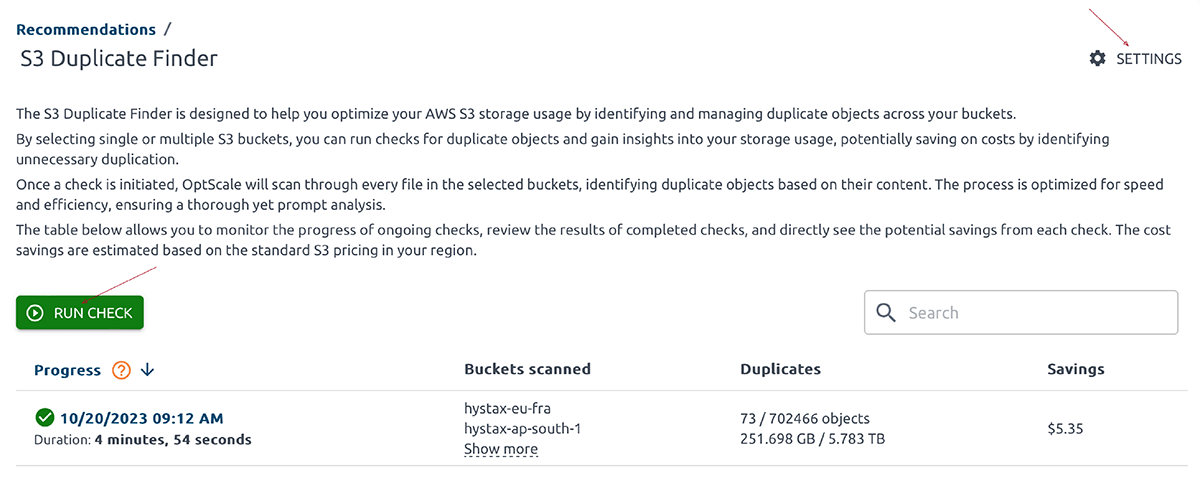

O cartão é clicável e leva você a uma página de resumo. Esta página mostra uma tabela de todos os lançamentos de cheques, fornecendo a opção de iniciar um novo cheque.

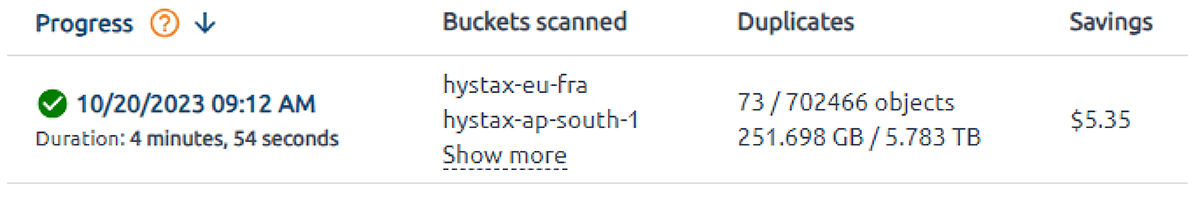

Mesa

As tabelas apresentam detalhes, incluindo o tempo de inicialização da verificação, uma lista de buckets digitalizados com links de recursos correspondentes, a contagem total de objetos duplicados em todos os buckets, seus tamanhos e a economia geral.

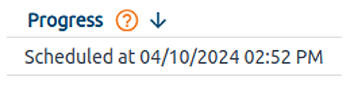

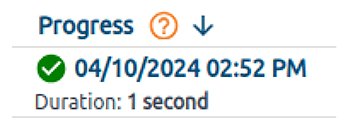

A coluna 'Progresso' indica o status atual de uma verificação específica. O rótulo de tempo indica o momento em que uma verificação foi iniciada. A verificação concluída com sucesso tem o status 'Concluído'.

Lançado recentemente – 'Criado'. Aguarde até que seja 'Concluído' para obter as informações sobre duplicatas.

A coluna 'Buckets Scanned' lista todos os buckets escaneados. Por padrão, somente os nomes dos dois primeiros buckets escaneados são exibidos nesta coluna. Clique no botão 'Show more' para visualizar os nomes restantes. A coluna 'Duplicates' representa o número de objetos duplicados encontrados durante uma verificação. A coluna 'Savings' indica a potencial economia de custos para remover os duplicados identificados.

Ações

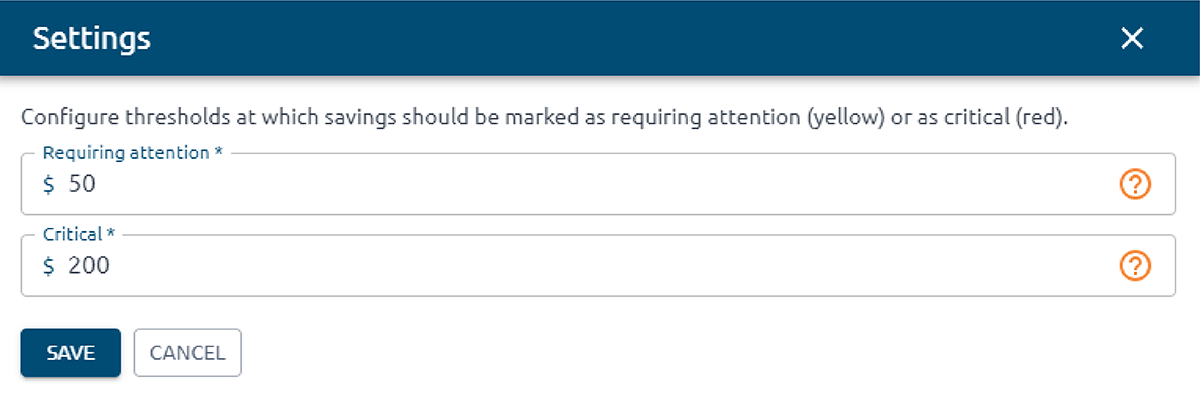

Configurações

O botão 'Configurações' aciona a abertura de um modal lateral contendo um formulário. Este formulário permite que os usuários configurem regras de limite de economia para colorir células em uma matriz de duplicação cruzada.

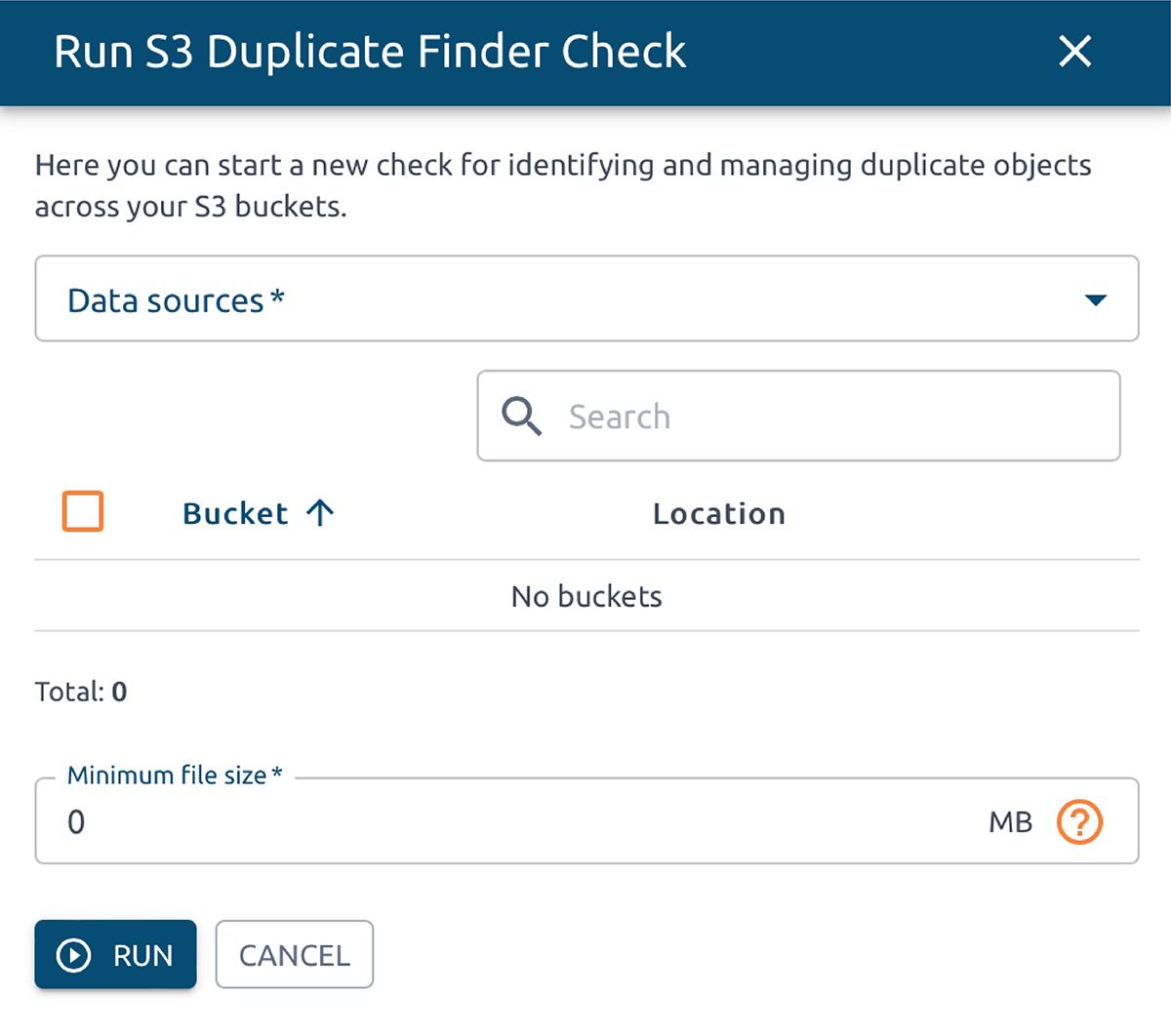

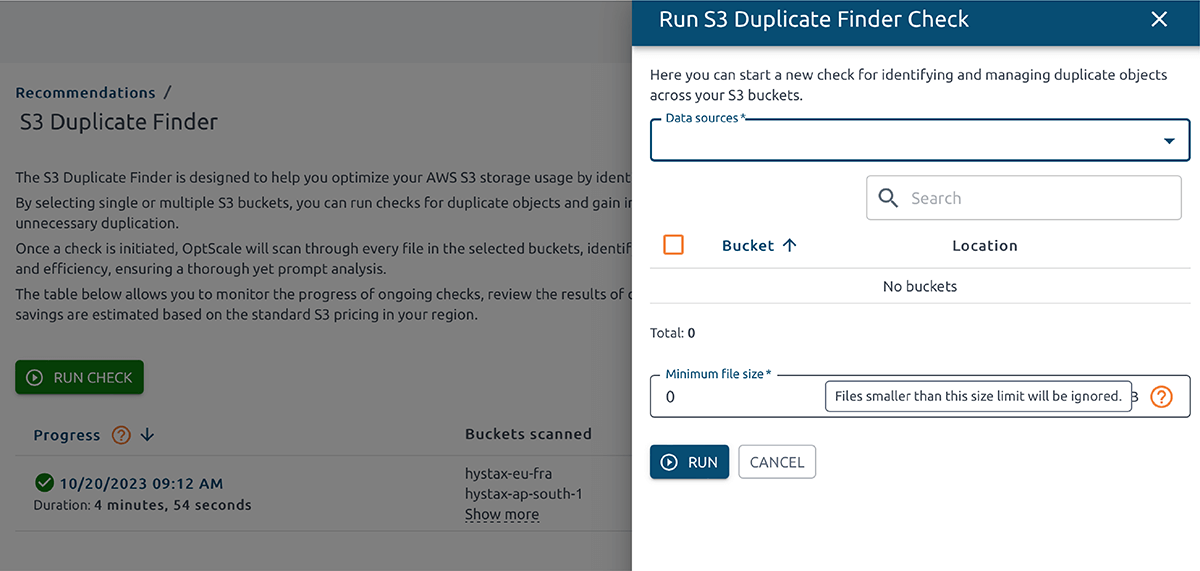

Executar verificação

O botão 'Executar verificação' aciona a abertura de um modal lateral contendo um formulário. Este formulário permite que os usuários configurem e iniciem uma nova verificação.

Otimização de custo de nuvem gratuita. Vida

Executar verificação de duplicação S3

O formulário permite selecionar o tipo de fonte de dados, buckets para verificação de duplicatas e definir um limite mínimo de tamanho de arquivo.

1. A seleção múltipla 'Fonte de dados' permite a seleção das fontes de dados desejadas onde os buckets serão verificados.

2. A tabela 'Buckets' permite selecionar os buckets desejados para serem verificados quanto a duplicatas. A lista de buckets depende da fonte de dados selecionada. O número máximo de buckets por verificação é 100.

3. O campo 'Tamanho mínimo do arquivo' permite que você especifique o limite mínimo de tamanho do arquivo. Arquivos que não atendem a esse requisito serão ignorados durante a verificação.

Quando "Executar", uma nota com a data e hora da verificação em execução aparece.

Quando a verificação for concluída, o conteúdo da célula ficará assim:

Clique neste link para ver uma tabela com duplicatas encontradas.

Use essas informações para obter insights sobre como minimizar suas despesas e economizar recursos.

Como encontrar objetos duplicados no OptScale? Visão geral dos resultados do S3 Duplicate Finder

Clicar no cartão de resumo 'Ir para o localizador de duplicatas S3' na aba 'Recomendações' da solução abrirá uma página de visão geral exibindo os resultados de uma verificação de duplicatas. Em seguida, selecione o item desejado na tabela que apresenta detalhes.

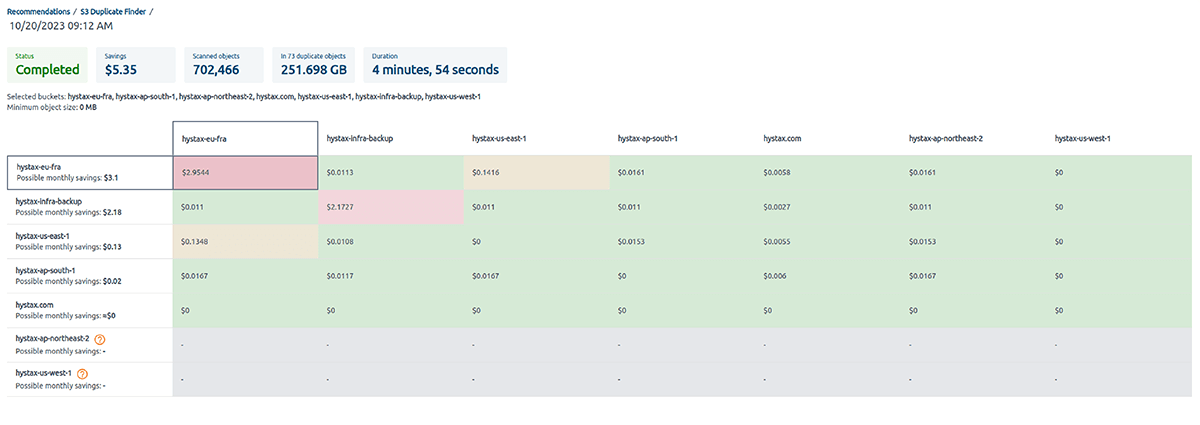

A página exibida apresenta informações importantes, como o status da verificação, a economia geral, o número de objetos digitalizados, o número total de objetos duplicados em todos os buckets e a duração da verificação.

Uma tabela de duplicatas entre buckets mostra informações sobre os valores duplicados entre buckets específicos. Os buckets 'From' são listados na primeira coluna, e os buckets 'To' são listados na primeira linha. As interseções de linhas e colunas exibem possíveis economias por mês. A tabela é classificada por 'Possíveis economias' por mês em ordem decrescente.

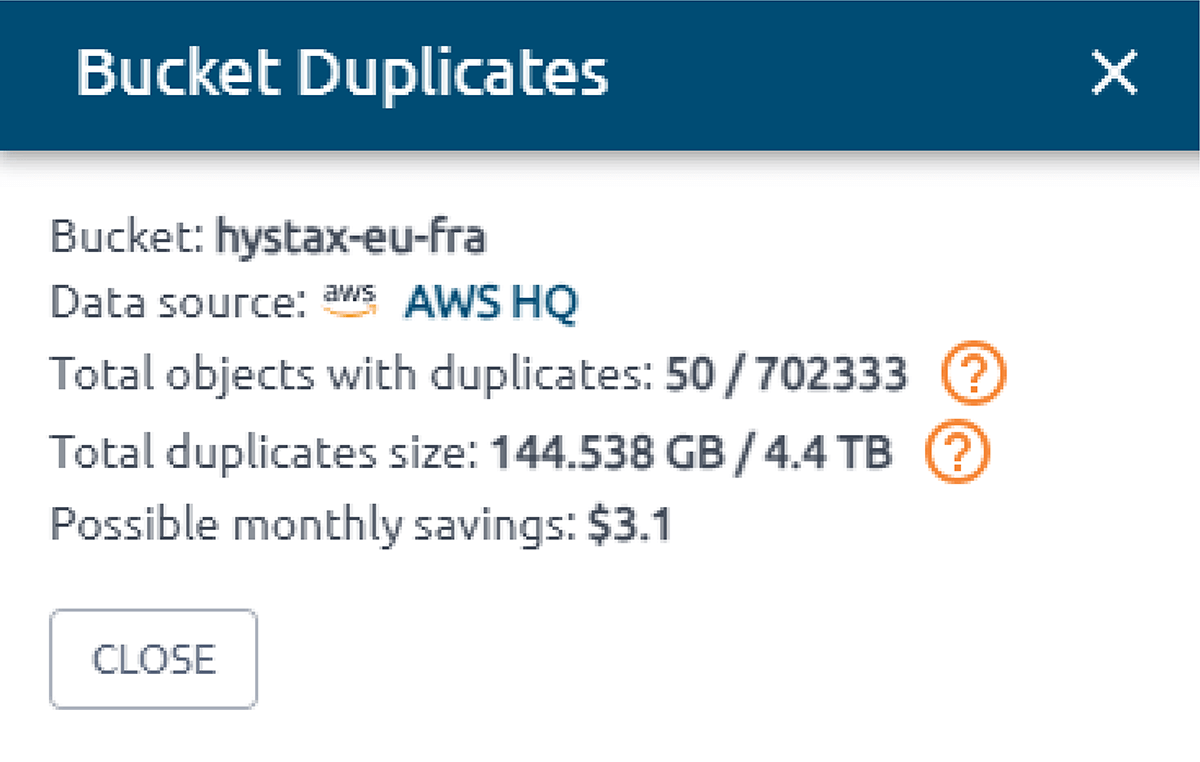

De detalhes do balde

- Nome do balde

- Possível economia por mês

- Possível economia por mês

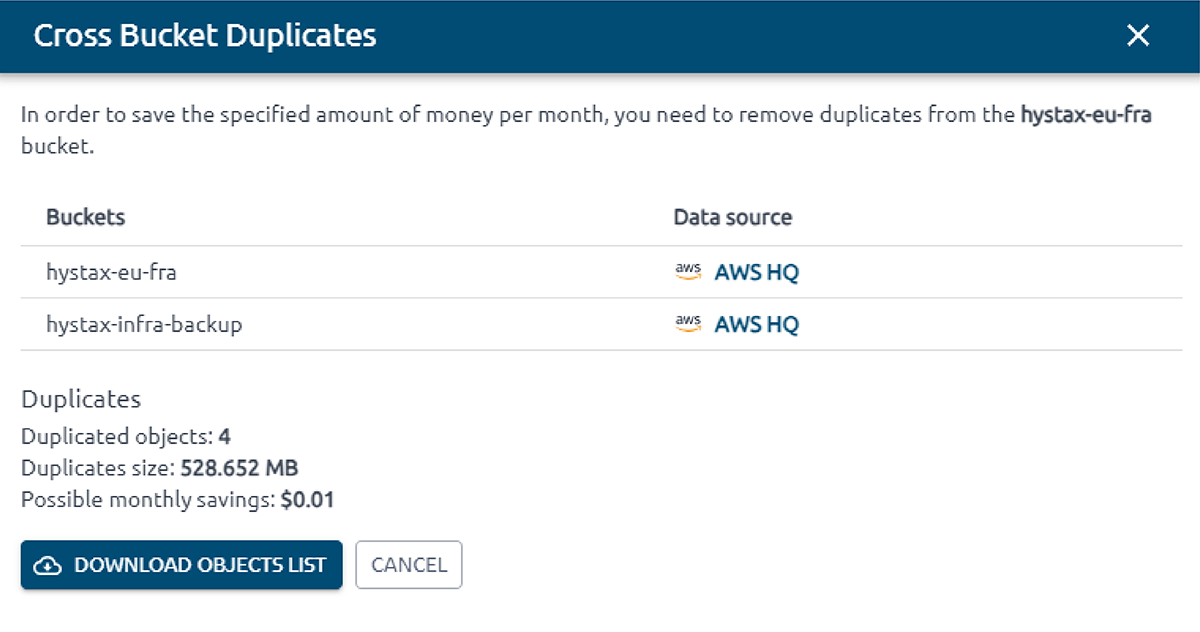

Detalhes do balde cruzado

Clicar em uma célula no corpo da tabela abre um modal lateral com informações detalhadas sobre duplicatas entre buckets.

O primeiro é um bucket 'from' e o segundo é um bucket 'to'. Baixe a lista de objetos para pesquisa.

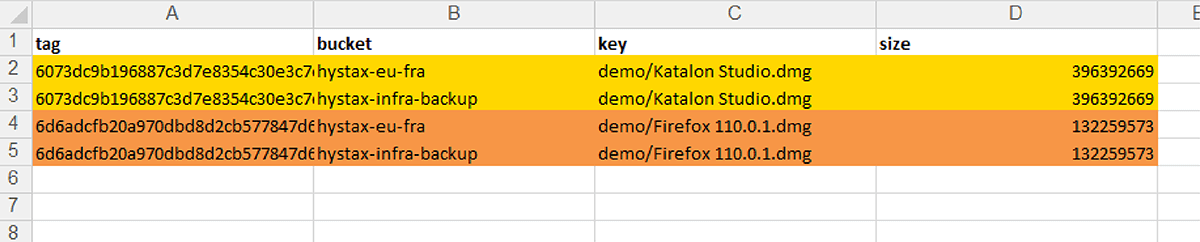

A tabela é projetada para que as próprias duplicatas, os buckets nos quais elas estão localizadas sejam imediatamente visíveis, e um caminho para as duplicatas (coluna-chave) e seu tamanho também sejam indicados. A coluna de tags é o ponto de referência para identificar duplicatas; as duplicatas têm a mesma coluna. Por padrão, a tabela é classificada pela coluna de tags, ou seja, quando você abre uma tabela, obtém imediatamente dados fáceis de trabalhar.

Encontre duplicatas no caminho da chave no bucket e remova-as se necessário para obter possíveis economias.

Projeto OptScale Github: https://github.com/hystax/optscale

Agradeceríamos se você nos desse uma estrela.

A plataforma OptScale permite que as empresas rastreiem seus gastos com nuvem, maximizem o uso de recursos e alcancem eficiência. Os recursos do OptScale MLOps beneficiam significativamente as equipes de ML/IA ao permitir o perfil de experimentos, ajuste de hiperparâmetros, aprimoramento de desempenho e recomendações de otimização de custos. O OptScale garante que suas operações de nuvem e IA sejam gerenciadas de forma econômica e eficiente.