Imagine un mundo en el que la inteligencia artificial (IA) y el aprendizaje automático (ML) forman parte de nuestra vida diaria. A medida que esta ola tecnológica sigue creciendo, la adopción de las mejores prácticas de MLOps ha pasado de ser una buena idea a una necesidad absoluta. Estas prácticas son como las estrellas guía que garantizan que los sistemas de IA y ML no solo crezcan de manera eficiente, sino que también sigan siendo confiables y seguros.

Ahora, imaginemos la escena: discusiones agitadas sobre nuevas regulaciones destinadas a dominar el ámbito de la IA, tal como Estrategia europea de inteligencia artificialEstas regulaciones son como las reglas de juego para las aplicaciones de IA en el mundo real. ¿Y adivinen qué? Están poniendo de relieve algo llamado "gobernanza de modelos". De repente, las empresas, grandes y pequeñas, se están dando cuenta de que es hora de poner en marcha su gobernanza de modelos.

Entonces, ¿qué es exactamente la gobernanza de modelos? Bueno, es como el guardián responsable del reino de la IA. Se asegura de que los sistemas de IA se comporten como es debido, siguiendo las reglas y siendo responsables de sus acciones. Y cuando la gobernanza de modelos se asocia con los procesos MLOps, a los que llamaremos gobernanza MLOps, ocurre la magia. Piense en la gobernanza MLOps como el mejor equipo que aporta muchos beneficios al ring.

Desde el punto de vista tecnológico, la gobernanza de MLOps actúa como una red de seguridad. Minimiza los riesgos y maximiza la calidad de los sistemas de ML que se lucen en el mundo real. Desde el punto de vista legal, es la capa de superhéroe que garantiza que estos sistemas cumplan las normas establecidas por los reguladores. Además, es como una insignia de honor que muestra a todo el mundo que el cumplimiento no es solo una palabra: es una forma de operar.

Ahora, echemos un vistazo a lo que este artículo tiene reservado para usted. En primer lugar, vamos a desentrañar los misterios de la gobernanza de modelos y su cómplice, la gobernanza de MLOps. Hablaremos sobre por qué la gobernanza de MLOps ha cobrado protagonismo. Y para mantener las cosas prácticas, profundizaremos en cómo puede configurar su marco de gobernanza. Este marco no se trata solo de reglas; también se trata de los procesos esenciales que hacen que MLOps funcione. Así que abróchese el cinturón mientras viajamos a través de la responsabilidad y la confiabilidad de la IA.

Explorando el concepto de gobernanza modelo

Comprender la gobernanza del modelo

La gobernanza de modelos en IA/ML consiste en implementar procesos para hacer un seguimiento de cómo se utilizan nuestros modelos. Es como seguir un conjunto de reglas.

Conexión con MLOps

Modelo de gobernanza y Operaciones de MLO (la gestión de operaciones de aprendizaje automático) van de la mano. La cantidad de gobernanza que necesitamos depende de cuántos modelos usemos y de las reglas en nuestro campo.

Variación en la integración

La forma en que combinamos la gobernanza del modelo ML con MLOps puede ser diferente en función de factores como la cantidad de modelos en acción y las regulaciones en nuestro dominio comercial.

Más modelos, más gobernanza

Si utilizamos muchos modelos, la gobernanza de modelos de ML se convierte en un aspecto importante de la forma en que gestionamos las operaciones de aprendizaje automático. Es una parte crucial de todo el proceso.

Núcleo del sistema ML

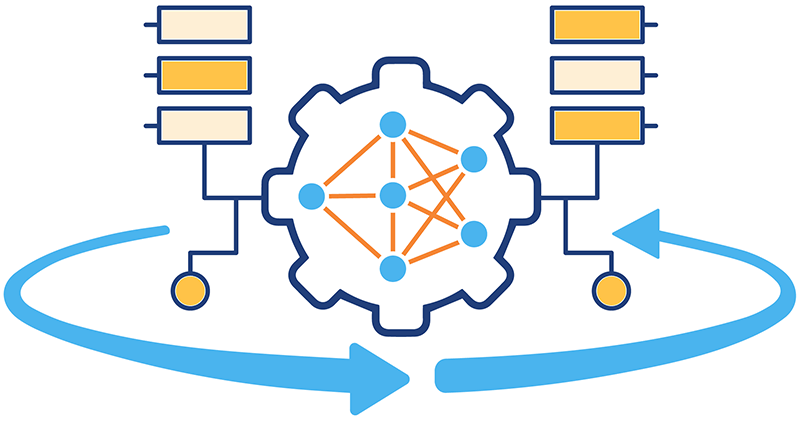

Piénselo de esta manera: a medida que utilizamos más la gobernanza de MLOps, se convierte en una parte central de cómo funciona toda nuestra configuración de aprendizaje automático. Es como el corazón del sistema.

La gobernanza de MLOps es el copiloto siempre confiable de su expedición de aprendizaje automático. No se trata solo de un conjunto de reglas; es su compañero que garantiza que cada paso del recorrido de su modelo, desde la creación hasta la implementación, sea tan fluido como la seda. Analicemos esta asociación dinámica en sus fases clave:

Fase 1: Exploración creativa

En las primeras etapas de Desarrollo de modelos y experimentaciónLa gobernanza de MLOps destaca por mantener un rastro de migas de pan digital. Es como dejar un rastro de pintura que brilla en la oscuridad para que siempre puedas volver sobre tus pasos. Además, tiene un don para compartir recursos, lo que hace que la colaboración dentro de tu equipo sea muy sencilla. Piensa en él como el Sherlock Holmes experto en tecnología de tu proyecto.

Fase 2: El gran debut

Cuando su modelo está listo para entrar en acción en el mundo real, la gobernanza de MLOps interviene como un mayordomo vigilante. Supervisa el rendimiento y se asegura de que su modelo se comporte de la mejor manera posible. ¿Seguridad? Cubierta. ¿Documentación? Presente y clara. Es como si su modelo tuviera un séquito de expertos que se encargaran de los detalles detrás de escena mientras su creación se lleva la atención.

Los dos pilares: gestión de datos y modelos

Imagine la gobernanza de MLOps como un gran palacio con dos torres majestuosas: Gestión de datos y Gestión de modelos. La primera torre protege sus datos, garantizando que se gestionen con cuidado y respeto por las pautas de su organización. La segunda torre se encarga de los modelos, su código y los procesos, orquestando una sinfonía armoniosa de eficiencia.

Así que, la próxima vez que te sumerjas en la gobernanza de MLOps, imagínala como tu fiel copiloto y un gran palacio, todo en uno. Es el arte de mantener las cosas en orden en el aprendizaje automático, lo que te permite concentrarte en la magia de la creación mientras él se encarga de la mecánica.

Optimización gratuita de costos de la nube y gestión mejorada de recursos ML/IA de por vida

¿Por qué es importante la gobernanza de MLOps?

La gobernanza del modelo MLOps aporta un nivel elevado de control y transparencia al funcionamiento de los modelos y canales de ML en escenarios del mundo real adaptados a las necesidades de las diferentes partes interesadas. Esta capacidad estructurada para rastrear actividades ofrece una serie de ventajas:

Optimización del rendimiento del modelo

Al identificar y abordar rápidamente errores y fallas, se garantiza que los modelos funcionen de manera óptima una vez implementados.

Garantizar la equidad

A través de funciones de explicabilidad, ayuda a garantizar continuamente la imparcialidad de los modelos al detectar y mitigar sesgos.

Mantener auditorías integrales

Documenta sin problemas el recorrido de los modelos, proporcionando un registro de auditoría completo que ayuda en el análisis y la comprensión.

Identificar y abordar riesgos potenciales

Permite la rápida identificación y resolución de posibles riesgos vinculados al ML, como el uso de datos sensibles o la exclusión inadvertida de determinados grupos de usuarios.

Esta capacidad confiable para llevar a cabo estas funciones puede tener un impacto real en el éxito de cualquier proyecto de aprendizaje automático, en particular aquellos de larga duración. La influencia va más allá de cumplir con las regulaciones y seguir técnicas de ingeniería superiores; se extiende a mejorar la reputación y ofrecer un mejor rendimiento del modelo para los usuarios finales.

Comprender un marco de gobernanza modelo

Un marco de gobernanza de modelos abarca todos los sistemas y procesos implementados para satisfacer las necesidades de gobernanza de modelos para cada modelo de aprendizaje automático operativo. Durante las fases iniciales de adopción del aprendizaje automático, esta gobernanza puede llevarse a cabo de forma manual, sin herramientas y métodos optimizados. Si bien este enfoque manual puede ser adecuado al principio, no logra establecer una base sólida para una gobernanza eficaz a medida que el equipo y sus procedimientos maduran. También obstaculiza la escalabilidad del aprendizaje automático en numerosos modelos.

La creación de un marco de gobernanza de modelos para el aprendizaje automático no es una tarea sencilla. Dada la naturaleza relativamente nueva de este campo y el panorama regulatorio en constante evolución, definir un marco de este tipo plantea desafíos y requiere estar muy atento a los requisitos cambiantes.

Sentar las bases para un marco modelo de gobernanza

El proceso de creación de un marco de gobernanza modelo se puede dividir en distintas fases:

Evaluación del cumplimiento normativo

Los distintos tipos de aplicaciones de aprendizaje automático suelen tener su propio conjunto de reglas y normas. Al configurar un nuevo proceso de producción para modelos de aprendizaje automático o al revisar uno existente, hay algunos pasos fundamentales que se deben tener en cuenta:

- Comprenda el contexto del aprendizaje automático: En primer lugar, conozca la categoría específica de aprendizaje automático con la que está tratando. Cada área puede tener requisitos regulatorios únicos.

- Identificar a los tutores: Decide quién será responsable de supervisar los procesos de gobernanza. Estas son las personas que se asegurarán de que todo funcione sin problemas.

- Definir las reglas: Ponga en orden sus políticas. Esto significa pensar en aspectos como la información personal identificable (PPI), las regulaciones especiales para su campo y las normas regionales que se aplican.

- Mezclar con MLOps: Integre estas reglas en su Plataforma MLOpsEsto garantiza que las regulaciones estén entretejidas en la estructura misma de su ciclo de vida del modelo.

- Involucrar y educar: Involucre a todos. Asegúrese de que todas las partes interesadas sepan qué está sucediendo y por qué es importante. La educación es vital para una gobernanza exitosa.

- Manténgase alerta: Como un guardián vigilante, manténgase al tanto de cómo van las cosas. Controle y perfeccione periódicamente sus procesos para asegurarse de que su modelo se mantenga en sintonía con las reglas a medida que evolucionan.

Con estos pasos, su viaje hacia una gobernanza de modelos eficaz se convierte en una aventura bien guiada, donde las normas y regulaciones no son obstáculos sino más bien el viento en sus velas.

Habilitación de la gobernanza de modelos a través de MLOps

Por lo tanto, la gobernanza de MLOps no es solo un libro de reglas; es una sinfonía de herramientas y prácticas que garantiza que los datos y los modelos avancen sin problemas en el escenario del éxito.

¿Cuáles son los factores que impulsan MLOps? Explora la motivación detrás de MLOps, las coincidencias entre MLOps y DevOps, y muchos otros aspectos esenciales → https://hystax.com/why-mlops-matters-bridging-the-gap-between-machine-learning-and-operations/

✔️ ¿Quieres que tus operaciones en la nube y ML/IA estén bajo control y que tus gastos cumplan con tus expectativas? Evalúa las capacidades y el potencial de una plataforma de código abierto como OptScale → https://hystax.com/introducing-optscale-public-release-an-open-source-powerhouse-for-finops-and-mlops/