Gerenciamento eficiente de dados: reduzindo o tamanho do backup com desduplicação e compactação

Os dados continuam a se expandir devido à sua crescente utilização na sociedade, no setor empresarial e globalmente. À medida que o volume de dados sendo processados aumenta, também aumenta a necessidade de maior capacidade de armazenamento. No entanto, fazer backup de grandes quantidades de dados apresenta desafios como altos custos e uso ineficiente de largura de banda e recursos de armazenamento. E se pudéssemos reduzir a carga de armazenamento preservando dados e informações de forma mais eficiente e econômica?

Técnicas de redução de dados fornecem uma solução viável para desafios de armazenamento ao permitir que os dados sejam minimizados sem sacrificar informações cruciais ou integridade. Esses métodos permitem que indivíduos, empresas e organizações façam backup de dados em um formato mais compacto, reduzindo o uso de largura de banda e garantindo que as informações armazenadas permaneçam acessíveis e intactas.

Este artigo se aprofunda nas técnicas primárias para reduzir o tamanho do backup: desduplicação e compactação. Ele também avalia os benefícios e desvantagens desses métodos e determina a abordagem mais eficaz para minimizar o tamanho do backup.

Por que as técnicas de redução de dados são essenciais?

Técnicas de redução de dados são vitais para lidar com os problemas associados a grandes arquivos de dados. Elas oferecem soluções para armazenar dados de forma eficiente para cortar custos, economizar espaço e reduzir o uso de largura de banda, tudo isso preservando a integridade dos dados e prevenindo perdas.

Empresas, organizações e indivíduos podem armazenar dados em um formato mais compacto, otimizando a capacidade de armazenamento e a largura de banda usando métodos de desduplicação e compressão. Essas técnicas garantem que não haja compensações negativas ao reduzir os tamanhos dos arquivos de backup, pois todos os dados — sejam redundantes ou exclusivos — podem ser acessados quando necessário. Além disso, tamanhos menores de dados simplificam o gerenciamento e o acesso aos dados, melhorando a produtividade.

Vamos explorar esses métodos de redução de dados em detalhes, incluindo como eles funcionam e se são necessários e valem a pena para reduzir o tamanho dos backups.

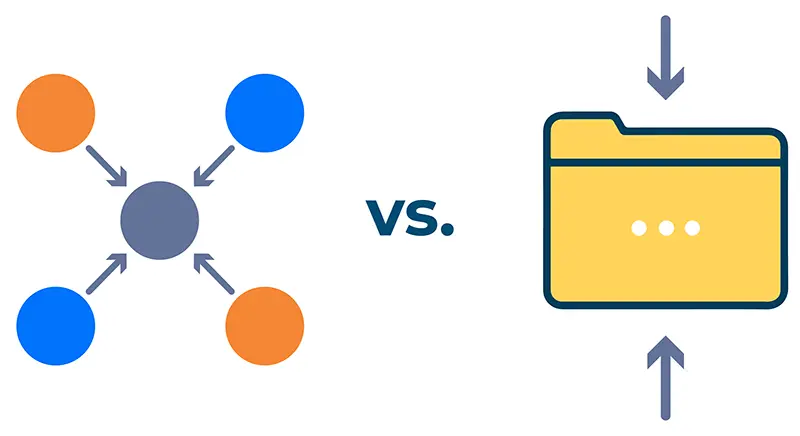

O que é desduplicação?

A desduplicação de dados é uma técnica que reduz os requisitos de armazenamento eliminando dados duplicados. Ela identifica e remove blocos de dados redundantes, mantendo apenas uma instância de cada bloco. As referências às duplicatas removidas são mantidas e serão restauradas se necessário.

Por exemplo, ao fazer backup de uma pasta, o algoritmo de desduplicação verifica se há blocos de dados duplicados. Ele identifica e retém apenas uma cópia de cada bloco exclusivo, indexando os dados para reconstrução precisa quando necessário. Esse processo garante que apenas blocos de dados distintos sejam armazenados, possibilitando a reconstrução dos dados originais conforme necessário.

Métodos de desduplicação

Existem várias abordagens para desduplicar blocos de dados, mas vamos nos concentrar nas três técnicas principais:

Desduplicação em linha

A deduplicação inline processa dados em tempo real. Conforme os dados são copiados, o algoritmo verifica se há informações redundantes, removendo dados duplicados e enviando apenas blocos exclusivos para o destino do backup.

Desduplicação pós-processo

Ao contrário da desduplicação em linha, a desduplicação pós-processo não filtra dados redundantes em tempo real. Em vez disso, ela desduplica os dados depois que eles foram copiados. Embora esse método alcance o mesmo resultado que a desduplicação em linha, ele requer mais espaço de armazenamento e largura de banda, pois todos os dados devem ser salvos antes que as duplicatas sejam removidas.

Desduplicação global

A desduplicação global integra métodos inline e pós-processo. Ela envolve um processo de desduplicação abrangente que verifica duplicatas em todo o conjunto de dados, garantindo que cada bloco redundante seja notado.

Vantagens da desduplicação

Retenção de dados: A deduplicação garante que nenhum dado seja perdido durante o processo de redução. Embora dados redundantes sejam removidos, os dados originais podem ser totalmente recuperados.

Consumo de largura de banda reduzido: Ao eliminar dados duplicados, a desduplicação reduz a largura de banda necessária para backup e transferência de dados.

Eficiência de custos: Tamanhos menores de dados reduzem os custos de armazenamento, tornando a desduplicação mais econômica.

Desempenho melhorado: Com a redução do tamanho dos dados, o processo de backup torna-se mais rápido e eficiente, economizando tempo e dinheiro.

Desvantagens da desduplicação

Possíveis problemas de integridade de dados: Se houver confusão, há risco de corrupção de dados e, se o bloco de referência for perdido, todos os blocos dependentes também poderão ser perdidos.

Complexidade: A implementação da desduplicação geralmente requer recursos de hardware adicionais, tornando o processo mais complexo e caro.

Eficácia limitada: A desduplicação é menos eficaz quando os dados não têm redundância, pois depende da presença de dados duplicados para reduzir os requisitos de armazenamento.

O que é compressão?

A compactação reduz o tamanho dos arquivos de dados codificando-os ou alterando-os para torná-los menores e mais compactos; diferentemente da desduplicação, que opera no nível do bloco, a compactação funciona no nível do arquivo. Durante a compactação, o algoritmo identifica e remove informações duplicadas ou não essenciais sem afetar a qualidade do conteúdo original. Os dados redundantes são descartados e as informações restantes são reorganizadas.

Métodos de compressão

Compressão com perdas

A compressão com perdas reduz o tamanho dos arquivos descartando partes menos críticas de arquivos multimídia. Por exemplo, um arquivo de áudio pode ser comprimido no formato MP3, reduzindo significativamente seu tamanho enquanto remove frequências inaudíveis e outros elementos não essenciais. Embora isso resulte em alguma perda de qualidade de áudio, a saída final permanece aceitável. Da mesma forma, fotografias RAW podem ser comprimidas no formato JPEG, onde ocorre uma pequena perda de dados, mas não afeta significativamente a qualidade final da imagem.

Compressão sem perdas

A compactação sem perdas reduz o tamanho dos arquivos identificando e eliminando redundâncias, preservando a capacidade de reconstruir o arquivo original. Este método usa marcadores de posição para dados repetitivos, permitindo que o arquivo original seja restaurado com precisão. A compactação sem perdas é comumente usada para backup de dados, onde manter a integridade dos dados é crucial. Ela também é usada para criar arquivos ZIP, que podem ser descompactados para recuperar os arquivos originais.

Vantagens da compressão

Espaço em disco reduzido: A compactação diminui o armazenamento necessário, liberando espaço para outros usos.

Transferência de arquivos mais rápida: Arquivos menores resultam em velocidades de transferência mais rápidas, fazendo backups e transferências mais eficientes.

Operações de leitura e gravação mais rápidas: Arquivos compactados são mais rápidos de ler e gravar do que seus equivalentes originais, melhorando a eficiência operacional.

Integridade de dados preservada: A compactação mantém a integridade dos dados garantindo que nenhuma informação crucial seja perdida quando os arquivos são compactados em formatos como ZIP.

Armazenamento econômico: Ao tornar os arquivos mais compactos, a compactação reduz os custos de armazenamento.

Desvantagens da compressão

Tempo de descompressão: Descompactar arquivos grandes pode ser demorado, potencialmente deixando as operações gerais mais lentas. Isso representa um trade-off entre tamanho de arquivo reduzido e tempo de descompactação.

Ferramentas especiais de descompressão necessárias: Arquivos descompactados geralmente exigem software específico, que pode não ser facilmente acessível a todos os usuários.

Aumento do uso de memória: O processo de compactação pode exigir recursos de memória adicionais, potencialmente causando problemas em sistemas com memória limitada.

Qual técnica de redução de dados é melhor para reduzir o tamanho do backup?

A deduplicação é o método mais amplamente utilizado para reduzir tamanhos de backup, particularmente para backups de armazenamento em nuvem. Ela reduz efetivamente o volume de dados, ajudando a gerenciar o espaço de armazenamento e a reduzir os custos associados.

A deduplicação garante que nenhum dado seja perdido durante o processo de redução, armazenando blocos de dados exclusivos e referenciando os redundantes. Isso garante que os dados originais permaneçam intactos e acessíveis sempre que necessário.

A compactação é outra técnica usada para reduzir os tamanhos de backup. No entanto, a compactação com perdas não é adequada para fins de backup porque descarta permanentemente alguns elementos de dados, o que pode levar à perda de informações críticas. A compactação com perdas é mais adequada para arquivos multimídia como áudio, vídeo e imagens. Em contraste, a compactação sem perdas é apropriada para dados de backup, pois retém os dados originais mesmo após a compactação. Embora tanto a desduplicação quanto a compactação sem perdas possam ser usadas para minimizar os tamanhos de backup, a desduplicação normalmente oferece desempenho mais rápido, pois não requer descompactação para recuperação de dados.

Para resultados ótimos, ambas as técnicas são recomendadas. Primeiro, a desduplicação para remover redundância é aplicada e, em seguida, a compactação sem perdas para reduzir ainda mais o tamanho do arquivo. Essa abordagem maximizará a eficiência do armazenamento e minimizará os custos de backup.

Resumindo

No ambiente rico em dados de hoje, a desduplicação e a compactação são essenciais para gerenciar tamanhos de backup. A proliferação de informações torna o backup de dados caro e intensivo em armazenamento. Devido à sua eficiência e eficácia, a desduplicação é o método preferido para reduzir tamanhos de backup. A compactação sem perdas complementa isso condensando ainda mais os arquivos sem comprometer a integridade dos dados.

Combinando ambas as técnicas — desduplicação seguida de compressão sem perdas —garante o gerenciamento de armazenamento mais eficiente. A desduplicação resolve a redundância, enquanto a compactação reduz o tamanho do arquivo, resultando em soluções de backup mais compactas e econômicas.

💡Utilizando Software de recuperação de desastres e backup em nuvem Hystax Acura é crucial para as empresas de hoje garantir a continuidade dos negócios, resiliência de TI, proteção contra perda de dados e armazenamento de dados resiliente e eficiente com uma taxa de desduplicação de até 70%. Estamos sempre à disposição sua disposição se você tiver alguma dúvida sobre como usá-lo.